Apa itu ReLU? (Rectified Linear Unit)

Bayangkan kamu punya saklar listrik. Saat kamu menekan saklar ke atas (positif), lampu menyala. Tapi saat saklar ditekan ke bawah (negatif), lampu tetap padam. ReLU bekerja seperti saklar ini:

- Jika masukan (x) positif → Keluarkan nilai asli (x).

- Jika masukan (x) negatif → Keluarkan 0 (mati total).

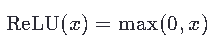

Matematikanya:

Contoh:

- Jika x=5, hasilnya 5.

- Jika x=−3, hasilnya 0.

Mengapa ReLU Penting?

ReLU adalah “pintu gerbang” yang membantu jaringan saraf tiruan (deep learning) belajar lebih cepat dan efisien. Berikut alasan utamanya:

1. Membuang “Sampah” yang Tidak Berguna

Jika jaringan menerima data yang “buruk” (misalnya, nilai negatif yang tidak relevan), ReLU mengabaikannya. Ini seperti menghapus komentar spam di email—fokus hanya pada informasi penting.

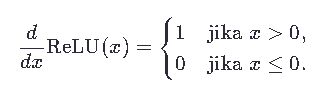

2. Mencegah Masalah “Gradien Hilang”

Bayangkan kamu naik tangga yang terus menerus. Jika setiap langkahmu jadi lebih kecil (gradien kecil), kamu tidak akan naik ke puncak. ReLU mencegah ini dengan memberikan gradien 1 untuk nilai positif, sehingga jaringan tetap “bersemangat” belajar.

Matematika gradiennya:

3. Sederhana Tapi Jago

ReLU hanya memerlukan operasi sederhana (bandingkan nilai dengan 0), sehingga komputasi jauh lebih cepat dibanding fungsi aktivasi lain seperti sigmoid (yang membutuhkan perhitungan eksponensial).

Contoh Aplikasi Nyata ReLU

1. Pengenalan Wajah

Ketika aplikasi seperti Face ID menganalisis foto, ReLU membantu fokus pada fitur penting (misalnya, tepi mata atau hidung) dengan mengabaikan nilai negatif yang tidak relevan.

2. Rekomendasi di Spotify/Netflix

Jaringan saraf menggunakan ReLU untuk memproses preferensi pengguna. Misalnya, jika kamu memberi rating negatif pada lagu, ReLU “menonaktifkan” sinyal buruk itu, sehingga rekomendasi lebih akurat.

3. Mobil Otonom

Sensor mobil otonom menghasilkan data seperti jarak dan kecepatan. ReLU memastikan jaringan hanya memproses informasi yang berguna (misalnya, jarak positif) dan mengabaikan “kekacauan” (nilai negatif).

Mengapa ReLU Lebih Baik dari Fungsi Lain?

| Fungsi Aktivasi | Kelebihan | Kekurangan |

|---|---|---|

| ReLU | Cepat, mencegah gradien hilang, mudah dihitung. | Bisa “mati” (tidak belajar) jika terlalu banyak nilai negatif. |

| Sigmoid | Keluaran terbatas (0-1), cocok untuk output klasifikasi. | Gradien kecil di ujung, lambat belajar. |

| Tanh | Keluaran simetris (-1 ke 1), bagus untuk data tertentu. | Masih punya masalah gradien kecil. |

Kesimpulan

ReLU adalah “pintu gerbang cerdas” yang membuat jaringan saraf tiruan:

- Lebih cepat (karena perhitungan sederhana).

- Lebih kuat (gradiennya stabil).

- Lebih fokus (mengabaikan data tidak berguna).

Dengan rumus sederhana max(0,x), ReLU telah menjadi tulang punggung inovasi AI di berbagai bidang, dari kesehatan digital hingga game realitas virtual!

Leave a Reply